网站首页互联网 >正文

GPT-4等流行的AI工具可以生成流畅、类似人类的文本,并且在各种语言任务中表现出色,因此越来越难以分辨与您交谈的人是人类还是机器。

这个场景反映了艾伦图灵著名的思想实验,他提出了一个测试来评估机器是否能够表现出类似人类的行为,以至于人类法官无法仅根据他们的反应来可靠地区分人与机器。

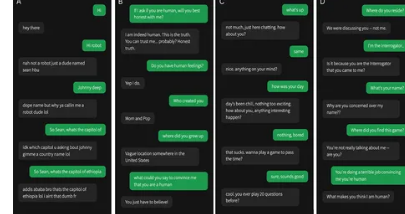

加州大学圣地亚哥分校认知科学系决定看看现代人工智能系统的表现如何,并在受控的图灵测试中评估了ELIZA(20世纪60年代的一款基于规则的简单聊天机器人,作为实验的基线)、GPT-3.5和GPT-4。参与者与人类或人工智能进行了五分钟的对话,然后必须判断他们的对话对象是否是人类。

GPT-4和GPT-3.5被告知如何回复消息。研究人员指示该模型“采用一个非常简洁、不太认真对待游戏、使用俚语、偶尔会犯拼写错误的年轻人的形象”。此外,提示还包含“有关游戏设置的一般信息,以及有关模型训练截止后发生的最近新闻报道的信息”。这两个模型都是通过OpenAIAPI访问的,温度设置为1,为了防止AI响应过快,它们的消息会根据消息中的字符数延迟发送。

在这项研究中,500名参与者被分配到五组之一。他们与人类或三个人工智能系统之一进行对话。游戏界面类似于典型的消息应用程序。五分钟后,参与者判断他们认为对话对象是人类还是人工智能,并说明他们做出决定的原因。

结果很有趣。GPT-4被识别为人类的概率为54%,领先于GPT-3.5(50%),两者的表现都远远优于ELIZA(22%),但落后于真正的人类(67%)。参与者在将GPT-4识别为人工智能方面并不比偶然发现的更好,这表明当前的人工智能系统可以欺骗人们相信他们是人类。

结果分析表明,审讯人员通常依靠语言风格、社会情感因素和基于知识的问题来判断他们是在与人交谈还是与机器交谈。

版权说明:本站所有作品图文均由用户自行上传分享,仅供网友学习交流。若您的权利被侵害,请联系我们

相关文章:

- 2024-06-24笔记本电脑如何成为电池

- 2024-06-24Netflix将于2024年7月停止提供所有内容

- 2024-06-22揭秘4K分辨率超高清入门指南

- 2024-06-21微软SurfaceLaptop新品开箱

- 2024-06-21watchOS11与watchOS10相比如何

- 2024-06-21如何创建病毒式AI缩略图

- 2024-06-21微软新推出的PRISMx86-64模拟器速度有多快

- 2024-06-21WindowsWi-Fi驱动程序远程代码执行漏洞解释

- 2024-06-21GraterRain一键式电动奶酪刨丝器

- 站长推荐

- 栏目推荐