网站首页教育知识 >正文

在一个充满恶意信息的时代,互联网上充斥着虚假陈述、歪曲事实、操纵图像和赤裸裸的谎言,至少在一个领域建立了一种荣誉制度来确保诚实和正直,这应该让人感到安慰:同行-学术出版物的审查过程。

在提交有关他们所做的研究的文章时,无数专业领域的科学家、医生和专家通常会将他们的工作提交给出版物,而出版物又会招募同一领域的专家来仔细审查他们的论文。

他们检查准确性、责任性和质量。如果论文未能达到出版物的高标准,则会被退回并进行建议的调整或被拒绝。当一篇论文通过了通常是强有力的、具有挑战性的审查时,它就可以发表了。

正如普利策奖得主《华盛顿邮报》记者克里斯·穆尼所说:“即使个别研究人员容易陷入自己的理论,更广泛的同行评审过程和制度化的怀疑主义旨在确保最终最好的想法占上风。”。

同行评审已经存在很长时间了。英国皇家学会哲学汇刊早在17世纪就制定了接受文章的正式程序,并且被认为是第一个采用后来被称为同行评审的程序。

据估计,每年发表514万篇同行评审文章,这些评审的时间超过1亿小时。

在此背景下,斯坦福大学的研究人员探索了法学硕士如何为审查过程做出贡献。

研究人员指出,审稿等待时间漫长(平均四个月)、成本(每年25亿美元)以及无偿聘用合格审稿人的问题,法学硕士的帮助可能对出版物和作者非常有益。

论文作者梁伟新表示,“高质量的同行评审越来越难获得”,《大型语言模型能否为研究论文提供有用的反馈?大规模的实证分析》发表在预印本服务器arXiv上3.“资历较浅或来自资源匮乏地区的研究人员尤其难以获得及时的反馈。”

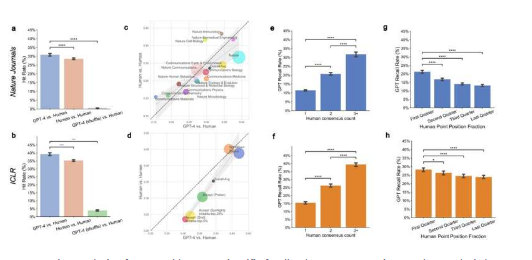

他们通过比较《自然》杂志和国际学习表示机器学习会议上数千篇论文的审稿人反馈与GPT-4生成的评论来测试他们的理论。他们发现人类和机器生成的评论提出的观点有31%到39%的重叠。对于较弱的提交(被拒绝的文章),GPT-4的表现甚至更好,44%的时间与人类评分者重叠。

研究人员还联系了这些论文的作者,发现超过一半的人将GPT-4评论描述为有帮助或非常有帮助。80%的作者表示,法学硕士的反馈比“至少某些”人工审稿人更有帮助。

“我们的结果表明法学硕士和人类反馈可以相辅相成,”梁说。他说,此类评论对于指导论文需要大量修改的作者特别有帮助。

“事实上,通过在审查前的科学过程中尽早提出这些担忧,这些论文及其报告的科学可能会得到改善,”梁说。

一位文章接受审阅的作者指出,GPT-4提出了人类审稿人忽视的观点。“GPT生成的评审建议我进行可视化,以便为可解释性提供更具体的案例。它还要求解决数据隐私问题。两者都很重要,而人类评审员忽略了这一点,”作者说。

然而,该报告警告说,法学硕士并不能替代人类监督。他们列举了一些局限性,例如评论过于模糊、未能提供“具体的改进技术领域”,以及在某些情况下缺乏“对模型架构和设计的深入批评”。

“值得注意的是,专家的反馈仍然是严格科学评估的基石,”梁说。“虽然与某些审稿人相当甚至更好,但当前的法学硕士反馈无法替代领域专家具体且深思熟虑的人类反馈。”

版权说明:本站所有作品图文均由用户自行上传分享,仅供网友学习交流。若您的权利被侵害,请联系我们

相关文章:

- 2023-10-20巴克莱银行与布里斯托尔引擎棚合作推动初创企业生态系统发展

- 2023-10-19报告称高等教育为英格兰西部经济贡献了38亿英镑

- 2023-10-19一种新方法将允许人们通过玩来学习编程

- 2023-10-18经济学家提出创新企业灵活管理可持续发展算法

- 2023-10-18为学龄前儿童提供大脑促进的新型节奏计划结果出炉

- 2023-10-17马胡林荣誉学院(MHC)也为学者追求个人学术兴趣铺平了道路

- 2023-10-17DanStrunk博士被任命为温州肯恩大学农业研究与教育中心下一任主任

- 2023-10-16DanStrunk博士被任命为温州肯恩大学农业研究与教育中心下一任主任

- 2023-10-142024雪佛兰Corvette价格上涨2,100美元现起价近7万美元

- 站长推荐

- 栏目推荐