网站首页数码科技 >正文

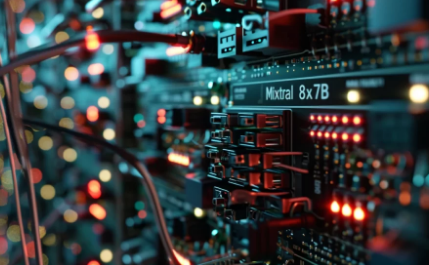

当谈到增强Mixtral8x7B(一个拥有惊人的870亿个参数的人工智能模型)的功能时,这项任务可能看起来令人畏惧。该模型属于专家混合(MoE)类别,以其效率和高质量输出而脱颖而出。它与GPT-4等产品竞争,并在某些性能基准测试中超越了LLaMA270B。本文将指导您完成Mixtral8x7B的微调过程,以确保它精确地满足您的计算任务的需求。

了解Mixtral8x7B的工作原理至关重要。它的工作原理是将提示路由给系统内最合适的“专家”,就像一个由专家组成的团队,每个专家都管理自己的领域。这种方法显着提高了模型的处理效率和输出质量。Mixtral-8x7B大型语言模型(LLM)是一种预训练的生成式稀疏专家混合模型,在大多数基准测试中均优于LLaMA270B。

微调Mixtral8x7BAI模型

要开始微调过程,建立一个强大的GPU环境非常重要。建议采用至少4个T4GPU的配置,以有效处理模型的计算需求。此设置将促进快速高效的数据处理,这对于优化过程至关重要。

鉴于模型规模庞大,采用量化和低秩适应(LURA)等技术至关重要。这些方法有助于压缩模型,从而在不牺牲性能的情况下减少其占用空间。这类似于微调机器以使其最佳运行。

在此示例中,Vigo数据集在微调过程中发挥着关键作用。它提供了一种特定类型的输出,有助于测试和改进模型的性能。初始步骤涉及加载和标记数据,确保数据矩阵的最大长度符合模型的要求。

将LURA应用于模型的线性层是一项战略举措。它有效地减少了可训练参数的数量,从而减少了所需资源的强度并加快了微调过程。这是管理模型计算需求的关键因素。

训练Mixtral8x7B包括设置检查点、微调学习率以及实施监控以防止过度拟合。这些措施对于促进有效学习并确保模型不会过于狭窄地适应训练数据至关重要。

模型微调后,使用Vigo数据集评估其性能非常重要。此评估将帮助您确定所做的改进并验证模型是否已准备好部署。

通过分享您的进展并寻求反馈来与人工智能社区互动,可以提供有价值的见解并带来进一步的改进。YouTube等平台非常适合鼓励此类互动和讨论。

优化Mixtral8x7B是一个细致且有益的过程。通过执行这些步骤并考虑模型的计算要求,您可以显着提高其特定应用程序的性能。这将带来更高效、更强大的人工智能工具,可以轻松处理复杂的任务。

版权说明:本站所有作品图文均由用户自行上传分享,仅供网友学习交流。若您的权利被侵害,请联系我们

相关文章:

- 2023-12-27通过GoogleBard保证自己面向未来在2024年及以后拥抱人工智能

- 2023-12-26如何设置您的新Android手机或平板电脑

- 2023-12-26使用GPT-Engineer.app的AI提示构建Web应用程序

- 2023-12-25受到Apple初代iPod的启发这款开源音乐播放器正是我需要的怀旧炸弹

- 2023-12-25苹果和谷歌可能即将推出他们的反跟踪跟踪技术

- 2023-12-25BlackPink将为MetaQuest3和OculusQuest2用户举办免费VR音乐会作为圣诞后礼物

- 2023-12-25StabilityAI推出AI3D模型和图像创建器StableZero123

- 2023-12-25在动态且不断变化的人工智能领域掌握各种模型之间的微妙差异变得越来越重要

- 2023-12-24MSI在CES2024之前推出首款配备MiniLED显示屏的18英寸4K120Hz笔记本电脑

- 站长推荐

- 栏目推荐